1. ชีวิตช่วงต้นและการศึกษา

ทิมนิต เกบรูมีภูมิหลังและประสบการณ์ชีวิตที่หล่อหลอมความสนใจของเธอในด้านจริยธรรมเทคโนโลยีอย่างลึกซึ้ง ตั้งแต่การเลี้ยงดูในเอธิโอเปียไปจนถึงการย้ายถิ่นฐานและการศึกษาในสหรัฐอเมริกา

1.1. การเกิดและภูมิหลัง

เกบรูเกิดและเติบโตในอาดดิสอาบาบา ประเทศเอธิโอเปีย บิดามารดาของเธอทั้งคู่มาจากเอริเทรีย บิดาของเธอเป็นวิศวกรไฟฟ้าและได้รับปริญญาเอก แต่เสียชีวิตเมื่อเธออายุเพียงห้าขวบ ทำให้เธอได้รับการเลี้ยงดูโดยมารดาซึ่งเป็นนักเศรษฐศาสตร์

1.2. การย้ายถิ่นฐานและประสบการณ์ในสหรัฐอเมริกา

เมื่ออายุ 15 ปี เกบรูต้องหลบหนีออกจากเอธิโอเปียในช่วงสงครามเอริเทรีย-เอธิโอเปีย หลังจากสมาชิกในครอบครัวบางคนถูกเนรเทศไปยังเอริเทรียและถูกบังคับให้เข้าร่วมการรบ ในตอนแรกเธอถูกปฏิเสธวีซ่าเข้าสหรัฐฯ และอาศัยอยู่ในสาธารณรัฐไอร์แลนด์ช่วงสั้นๆ ก่อนที่จะได้รับสถานะผู้ลี้ภัยทางการเมืองในสหรัฐอเมริกา ซึ่งเธออธิบายว่าเป็นประสบการณ์ที่ "น่าสังเวช" เกบรูได้ตั้งรกรากในซอมเมอร์วิลล์ รัฐแมสซาชูเซตส์ เพื่อเข้าเรียนในโรงเรียนมัธยมปลาย ที่นั่นเธอเริ่มประสบกับการเลือกปฏิบัติทางเชื้อชาติทันที โดยครูบางคนปฏิเสธที่จะให้เธอเรียนหลักสูตร Advanced Placement บางวิชา ทั้งที่เธอเป็นนักเรียนที่มีผลการเรียนดีเยี่ยม

หลังจากสำเร็จการศึกษาระดับมัธยมปลาย เหตุการณ์หนึ่งที่เกี่ยวข้องกับการเผชิญหน้ากับตำรวจได้กำหนดเส้นทางให้เกบรูมุ่งเน้นไปที่จริยธรรมในเทคโนโลยี เพื่อนของเธอซึ่งเป็นหญิงผิวดำถูกทำร้ายในบาร์ และเกบรูได้โทรศัพท์แจ้งตำรวจ แต่แทนที่จะมีการแจ้งความเรื่องการทำร้ายร่างกาย เพื่อนของเธอกลับถูกจับกุมและควบคุมตัวในห้องขัง เกบรูเรียกเหตุการณ์นี้ว่าเป็นจุดเปลี่ยนสำคัญและเป็น "ตัวอย่างที่ชัดเจนของการเหยียดเชื้อชาติเชิงระบบ"

1.3. การศึกษาและจุดเริ่มต้นอาชีพนักวิจัย

ในปี พ.ศ. 2544 เกบรูได้รับการตอบรับเข้าศึกษาที่มหาวิทยาลัยสแตนฟอร์ด ที่นั่นเธอได้รับปริญญาวิทยาศาสตรบัณฑิตและวิทยาศาสตรมหาบัณฑิตสาขาวิศวกรรมไฟฟ้า และปริญญาเอกสาขาคอมพิวเตอร์วิทัศน์ในปี พ.ศ. 2560 โดยมีเฟยเฟย หลี่ เป็นอาจารย์ที่ปรึกษาในหลักสูตรปริญญาเอกของเธอ

ขณะศึกษาอยู่ที่สแตนฟอร์ด เกบรูได้ฝึกงานที่บริษัท Apple ในแผนกฮาร์ดแวร์ โดยทำงานเกี่ยวกับการสร้างวงจรสำหรับส่วนประกอบเสียง และได้รับข้อเสนอให้ทำงานเต็มเวลาในปีถัดมา ผู้จัดการของเธอที่ Apple กล่าวกับนิตยสาร Wired ว่าเธอเป็นคน "ไม่เกรงกลัว" และเป็นที่ชื่นชอบของเพื่อนร่วมงาน เธอได้พัฒนาอัลกอริทึมการประมวลผลสัญญาณสำหรับไอแพดรุ่นแรก ในเวลานั้น เธอกล่าวว่าเธอไม่ได้พิจารณาถึงการใช้งานที่อาจนำไปสู่การเฝ้าระวัง โดยระบุว่า "ฉันแค่พบว่ามันน่าสนใจในทางเทคนิค"

ในช่วงการเลือกตั้งประธานาธิบดีสหรัฐอเมริกา พ.ศ. 2551 เกบรูได้รณรงค์หาเสียงสนับสนุนบารัก โอบามา

เกบรูนำเสนอผลงานวิจัยระดับปริญญาเอกของเธอในการแข่งขัน LDV Capital Vision Summit ปี พ.ศ. 2560 ซึ่งเป็นเวทีที่นักวิทยาศาสตร์คอมพิวเตอร์วิทัศน์นำเสนอผลงานของตนต่อสมาชิกในอุตสาหกรรมและนักลงทุนร่วมลงทุน เกบรูชนะการแข่งขันนี้ ซึ่งนำไปสู่ความร่วมมือหลายครั้งกับผู้ประกอบการและนักลงทุนรายอื่นๆ

ทั้งในระหว่างหลักสูตรปริญญาเอกในปี พ.ศ. 2559 และในปี พ.ศ. 2561 เกบรูได้เดินทางกลับไปยังเอธิโอเปียเพื่อเข้าร่วมโครงการ AddisCoder ของเจลานี เนลสัน ซึ่งเป็นโครงการด้านการเขียนโปรแกรม

ขณะที่กำลังทำปริญญาเอก เกบรูได้เขียนบทความที่ยังไม่ได้รับการตีพิมพ์เกี่ยวกับความกังวลของเธอต่ออนาคตของ AI เธอเขียนถึงอันตรายของการขาดความหลากหลายในสาขานี้ โดยมีศูนย์กลางอยู่ที่ประสบการณ์ของเธอกับตำรวจ และการสอบสวนของ ProPublica เกี่ยวกับการทำนายอาชญากรรม ซึ่งเปิดเผยถึงการฉายภาพอคติของมนุษย์ในการเรียนรู้ของเครื่อง ในบทความดังกล่าว เธอวิพากษ์วิจารณ์ "วัฒนธรรมแบบชมรมเด็กผู้ชาย" โดยสะท้อนถึงประสบการณ์ของเธอในการประชุมที่มีผู้เข้าร่วมชายที่มึนเมาคุกคามทางเพศเธอ และวิจารณ์การบูชาบุคคลสำคัญในสาขานี้

2. อาชีพและกิจกรรม

เส้นทางอาชีพของทิมนิต เกบรูแสดงให้เห็นถึงความมุ่งมั่นของเธอในการสร้างสรรค์เทคโนโลยีที่เป็นธรรมและมีความรับผิดชอบ ตั้งแต่บทบาทแรกๆ ในบริษัทเทคโนโลยี ไปจนถึงผลงานที่มีอิทธิพลที่ Google และการก่อตั้งสถาบันวิจัยอิสระของเธอ

2.1. อาชีพช่วงต้น (Apple, Microsoft)

เกบรูเข้าร่วม Apple ในฐานะนักศึกษาฝึกงานขณะอยู่ที่สแตนฟอร์ด โดยทำงานในแผนกฮาร์ดแวร์เพื่อสร้างวงจรสำหรับส่วนประกอบเสียง และได้รับข้อเสนอตำแหน่งเต็มเวลาในปีถัดมา ผู้จัดการของเธอที่ Apple กล่าวกับนิตยสาร Wired ว่าเธอเป็นคน "ไม่เกรงกลัว" และเป็นที่ชื่นชอบของเพื่อนร่วมงาน ในระหว่างที่ทำงานที่ Apple เกบรูเริ่มสนใจการสร้างซอฟต์แวร์มากขึ้น โดยเฉพาะอย่างยิ่งคอมพิวเตอร์วิทัศน์ที่สามารถตรวจจับรูปร่างของมนุษย์ได้ เธอได้พัฒนาอัลกอริทึมการประมวลผลสัญญาณสำหรับไอแพดรุ่นแรก ในเวลานั้น เธอกล่าวว่าเธอไม่ได้พิจารณาถึงการใช้งานที่อาจนำไปสู่การเฝ้าระวัง โดยระบุว่า "ฉันแค่พบว่ามันน่าสนใจในทางเทคนิค"

หลังจากออกจากบริษัทไปนาน ในช่วงการเคลื่อนไหว #AppleToo ในฤดูร้อนปี พ.ศ. 2564 ซึ่งนำโดยวิศวกรของ Apple ชื่อ เชอร์ สการ์เล็ตต์ ผู้ซึ่งได้ปรึกษาหารือกับเกบรู เกบรูเปิดเผยว่าเธอประสบกับ "สิ่งเลวร้ายมากมาย" และ "สงสัยมาตลอดว่าพวกเขาจัดการหลบเลี่ยงการถูกจับตามองได้อย่างไร" เธอกล่าวว่าการตรวจสอบความรับผิดชอบที่ Apple นั้นล่าช้ามานาน และเตือนว่าพวกเขาไม่สามารถหลบเลี่ยงการถูกจับตามองไปได้อีกนาน เกบรูยังวิพากษ์วิจารณ์วิธีการที่สื่อนำเสนอข่าวเกี่ยวกับ Apple และบริษัทเทคโนโลยียักษ์ใหญ่อื่นๆ โดยกล่าวว่าสื่อช่วยปกป้องบริษัทเหล่านั้นจากการตรวจสอบของสาธารณะ

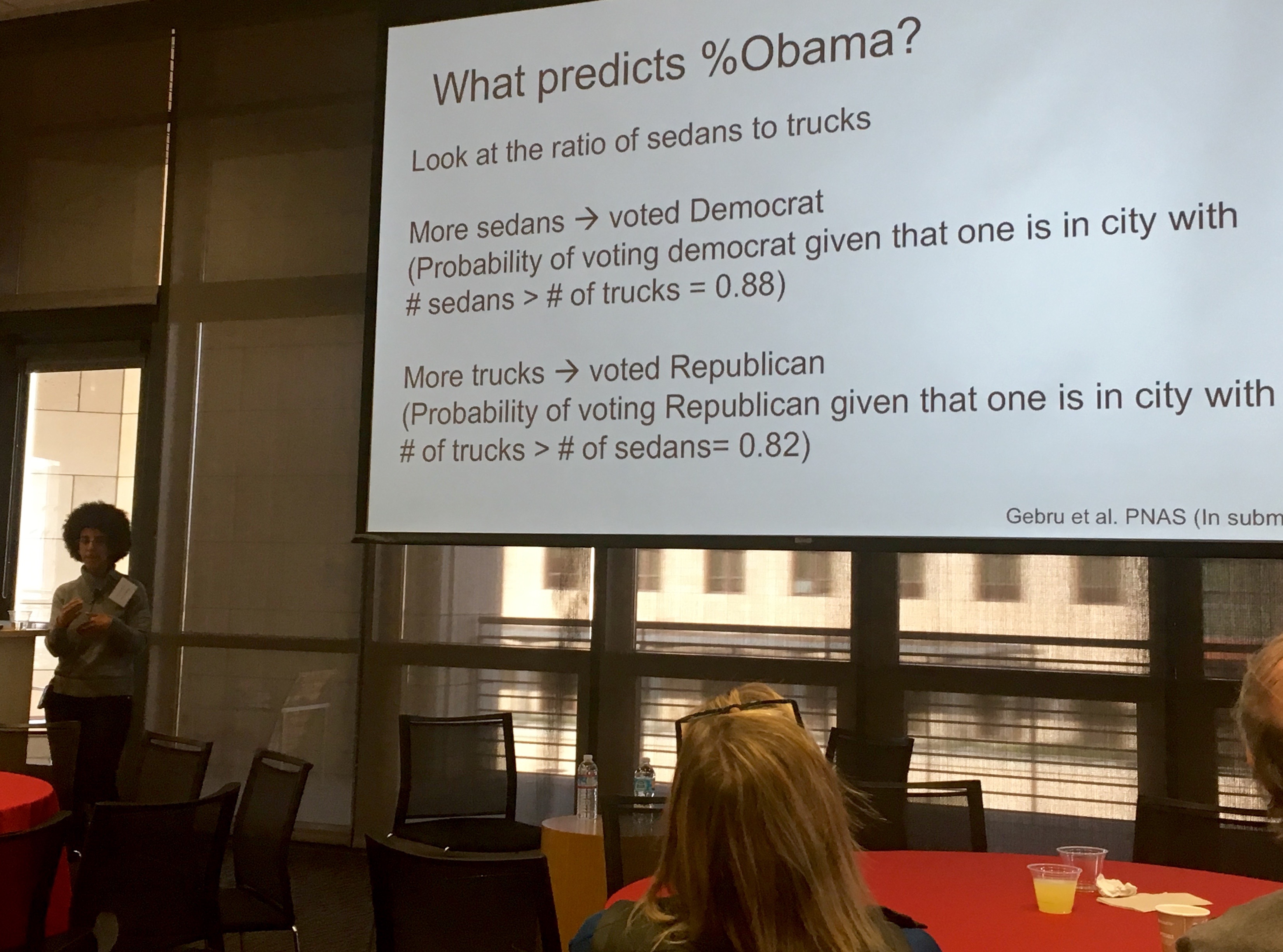

ในปี พ.ศ. 2556 เกบรูเข้าร่วมห้องปฏิบัติการของเฟยเฟย หลี่ ที่สแตนฟอร์ด เธอใช้การทำเหมืองข้อมูลจากภาพที่เปิดเผยต่อสาธารณะ เธอสนใจจำนวนเงินที่องค์กรภาครัฐและเอกชนใช้ไปในการพยายามรวบรวมข้อมูลเกี่ยวกับชุมชน เพื่อสำรวจทางเลือกอื่น เกบรูได้รวมการเรียนรู้เชิงลึกเข้ากับกูเกิล สตรีทวิว เพื่อประมาณการข้อมูลประชากรศาสตร์ของย่านต่างๆ ในสหรัฐอเมริกา โดยแสดงให้เห็นว่าคุณลักษณะทางเศรษฐกิจและสังคม เช่น รูปแบบการลงคะแนนเสียง รายได้ เชื้อชาติ และการศึกษา สามารถอนุมานได้จากการสังเกตการณ์รถยนต์ หากจำนวนรถกระบะมีมากกว่าจำนวนรถซีดาน ชุมชนนั้นก็มีแนวโน้มที่จะลงคะแนนเสียงให้พรรครีพับลิกันมากกว่า พวกเขาได้วิเคราะห์ภาพมากกว่า 15 M ภาพจาก 200 เมืองที่มีประชากรมากที่สุดในสหรัฐอเมริกา ผลงานนี้ได้รับการรายงานข่าวอย่างกว้างขวางในสื่อต่างๆ เช่น BBC News, Newsweek, The Economist และ The New York Times

ในปี พ.ศ. 2558 เกบรูเข้าร่วมการประชุมชั้นนำของสาขาคือ Neural Information Processing Systems (NIPS) ที่มอนทรีออล ประเทศแคนาดา จากผู้เข้าร่วม 3,700 คน เธอสังเกตว่ามีนักวิจัยผิวดำเพียงไม่กี่คน เมื่อเธอเข้าร่วมอีกครั้งในปีถัดมา เธอได้นับจำนวนและพบว่ามีชายผิวดำเพียงห้าคน และเธอเป็นผู้หญิงผิวดำเพียงคนเดียวจากผู้แทน 8,500 คน ร่วมกับเพื่อนร่วมงาน เรดิเอต อาเบเบ เกบรูได้ก่อตั้ง Black in AI ซึ่งเป็นชุมชนของนักวิจัยผิวดำที่ทำงานด้านปัญญาประดิษฐ์ Black in AI มีเป้าหมายที่จะทำให้การเข้าถึงสาขาปัญญาประดิษฐ์ (AI) เป็นประชาธิปไตยมากขึ้น โดยการเพิ่มการมีอยู่ การมองเห็น และความเป็นอยู่ที่ดีของมืออาชีพและผู้นำผิวดำในสาขานี้

ในฤดูร้อนปี พ.ศ. 2560 เกบรูเข้าร่วมไมโครซอฟท์ในฐานะนักวิจัยหลังปริญญาเอกในห้องปฏิบัติการ FATE (Fairness, Accountability, Transparency, and Ethics in AI) ในปี พ.ศ. 2560 เกบรูได้กล่าวในการประชุม Fairness and Transparency ซึ่ง MIT Technology Review ได้สัมภาษณ์เธอเกี่ยวกับอคติที่มีอยู่ในระบบ AI และวิธีที่การเพิ่มความหลากหลายในทีม AI สามารถแก้ไขปัญหานั้นได้ ในการสัมภาษณ์กับ แจ็กกี้ สโนว์ สโนว์ถามเกบรูว่า "การขาดความหลากหลายบิดเบือนปัญญาประดิษฐ์และโดยเฉพาะอย่างยิ่งคอมพิวเตอร์วิทัศน์อย่างไร" และเกบรูชี้ให้เห็นว่ามีอคติที่มีอยู่ในนักพัฒนาซอฟต์แวร์ ขณะอยู่ที่ไมโครซอฟท์ เกบรูได้ร่วมเขียนบทความวิจัยชื่อ Gender Shades ซึ่งกลายเป็นชื่อของโครงการที่กว้างขึ้นของสถาบันเทคโนโลยีแมสซาชูเซตส์ ที่นำโดยผู้ร่วมเขียน จอย บูโอลัมวินี ทั้งคู่ได้ตรวจสอบซอฟต์แวร์รู้จำใบหน้า และพบว่าในการใช้งานเฉพาะอย่างหนึ่ง ผู้หญิงผิวดำมีโอกาสถูกจดจำน้อยกว่าผู้ชายผิวขาวถึง 35%

2.2. การวิจัยจริยธรรม AI ที่ Google

เกบรูเข้าร่วม Google ในปี พ.ศ. 2561 โดยเธอร่วมเป็นผู้นำทีมด้านจริยธรรมของปัญญาประดิษฐ์กับมาร์กาเร็ต มิตเชลล์ เธอศึกษาผลกระทบของปัญญาประดิษฐ์ โดยมุ่งหวังที่จะปรับปรุงความสามารถของเทคโนโลยีเพื่อประโยชน์ทางสังคม

ในปี พ.ศ. 2562 เกบรูและนักวิจัยปัญญาประดิษฐ์คนอื่นๆ "ลงนามในจดหมายเรียกร้องให้ Amazon หยุดขายเทคโนโลยีรู้จำใบหน้าให้กับหน่วยงานบังคับใช้กฎหมาย เนื่องจากมีอคติต่อผู้หญิงและคนผิวสี" โดยอ้างถึงการศึกษาที่ดำเนินการโดยนักวิจัยของ MIT ซึ่งแสดงให้เห็นว่าระบบรู้จำใบหน้าของ Amazon มีปัญหาในการระบุตัวผู้หญิงผิวคล้ำมากกว่าซอฟต์แวร์รู้จำใบหน้าของบริษัทเทคโนโลยีอื่นๆ ในการสัมภาษณ์กับ The New York Times เกบรูได้แสดงความเห็นเพิ่มเติมว่าเธอเชื่อว่าเทคโนโลยีรู้จำใบหน้านั้นอันตรายเกินไปที่จะนำมาใช้เพื่อวัตถุประสงค์ในการบังคับใช้กฎหมายและความปลอดภัยในปัจจุบัน

2.3. เอกสาร 'Stochastic Parrots' และการออกจาก Google

ในปี พ.ศ. 2563 เกบรูและผู้ร่วมเขียนอีกห้าคนได้เขียนบทความเรื่อง "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜" (เกี่ยวกับอันตรายของนกแก้วสุ่ม: แบบจำลองภาษาจะใหญ่เกินไปได้หรือไม่?) บทความนี้ได้ตรวจสอบความเสี่ยงของแบบจำลองภาษาขนาดใหญ่อย่างละเอียด รวมถึงผลกระทบต่อสิ่งแวดล้อม ต้นทุนทางการเงิน ความไม่โปร่งใสของแบบจำลองขนาดใหญ่ ศักยภาพที่ LLMs จะแสดงอคติต่อกลุ่มบางกลุ่ม การที่ LLMs ไม่สามารถเข้าใจภาษาที่พวกมันประมวลผลได้ และการใช้ LLMs เพื่อเผยแพร่ข้อมูลเท็จ

ในเดือนธันวาคม พ.ศ. 2563 การจ้างงานของเธอกับ Google สิ้นสุดลงหลังจากผู้บริหารของ Google ขอให้เธอถอนบทความก่อนการตีพิมพ์ หรือลบชื่อผู้เขียนที่เป็นพนักงานของ Google ทั้งหมดออกจากบทความ จากผู้เขียนหกคน มีเพียง เอมิลี เอ็ม. เบนเดอร์ เท่านั้นที่ไม่ได้เป็นพนักงานของ Google ในขณะนั้น ในจดหมายหกหน้าที่ส่งไปยังรายชื่อผู้ร่วมงานภายใน เกบรูอธิบายว่าเธอถูกเรียกประชุมกะทันหัน ซึ่งเธอถูกขอให้ถอนบทความ และเธอได้ขอทราบชื่อและเหตุผลของทุกคนที่ตัดสินใจดังกล่าว พร้อมคำแนะนำในการแก้ไขบทความให้เป็นที่พอใจของ Google เธอกล่าวว่าเธอจะหารือกับ Google เกี่ยวกับวันที่สิ้นสุดการจ้างงานหลังจากเวลาที่เหมาะสม หากไม่ได้รับข้อมูลดังกล่าว Google ไม่ได้ตอบสนองคำขอของเธอและยุติการจ้างงานของเธอทันที โดยประกาศว่าพวกเขายอมรับการลาออกของเธอ เกบรูยืนยันว่าเธอไม่ได้เสนอลาออกอย่างเป็นทางการ แต่เพียงแค่ขู่ว่าจะลาออกเท่านั้น เจฟฟ์ ดีน หัวหน้าฝ่ายวิจัย AI ของ Google ตอบกลับด้วยอีเมลโดยกล่าวว่าพวกเขาตัดสินใจเช่นนั้นเนื่องจากบทความดังกล่าวละเลยการวิจัยล่าสุดที่เกี่ยวข้องมากเกินไปเกี่ยวกับวิธีการบรรเทาปัญหาบางอย่างที่อธิบายไว้ในบทความ เกี่ยวกับผลกระทบต่อสิ่งแวดล้อม และอคติของแบบจำลองเหล่านี้

ดีนได้เผยแพร่อีเมลภายในของเขาเกี่ยวกับการออกจากงานของเกบรูและความคิดเห็นของเขาในเรื่องนี้ โดยปกป้องกระบวนการบทความวิจัยของ Google เพื่อ "จัดการกับปัญหาที่ทะเยอทะยาน แต่ต้องทำอย่างรับผิดชอบ" เกบรูและคนอื่นๆ โทษว่าการตีพิมพ์ครั้งแรกนี้ และความเงียบของดีนในเรื่องนี้ในภายหลัง ซึ่งเกบรูกล่าวว่าทั้งสองสิ่งนี้ได้กระตุ้นและส่งเสริมการคุกคามที่ตามมาอย่างใกล้ชิด เกบรูถูกคุกคามอย่างต่อเนื่องโดยบัญชีหุ่นเชิดและนักเลงคีย์บอร์ดจำนวนมากบน ทวิตเตอร์ โดยมีการแสดงความคิดเห็นที่เหยียดเชื้อชาติและหยาบคาย เกบรูและผู้สนับสนุนของเธอกล่าวหาว่าการคุกคามบางส่วนมาจากนักวิจัยด้านการเรียนรู้ของเครื่อง เปโดร โดมิงโกส และนักธุรกิจ ไมเคิล ลิสแซก ซึ่งกล่าวว่างานของเธอเป็น "การสนับสนุนที่ปลอมตัวเป็นวิทยาศาสตร์" ลิสแซกยังถูกกล่าวหาว่าคุกคามมิตเชลล์และเบนเดอร์ รวมถึงเพื่อนร่วมงานคนอื่นๆ ในทีมเก่าของเกบรู ทวิตเตอร์ได้ระงับการเข้าถึงบัญชีของลิสแซกชั่วคราวเมื่อวันที่ 1 กุมภาพันธ์ พ.ศ. 2564

เกบรูยืนยันซ้ำแล้วซ้ำเล่าว่าเธอถูกไล่ออก และพนักงาน Google เกือบ 2,700 คน และนักวิชาการและผู้สนับสนุนภาคประชาสังคมมากกว่า 4,300 คนได้ลงนามในจดหมายประณามการถูกไล่ออกของเกบรู สมาชิกรัฐสภาเก้าคนได้ส่งจดหมายถึง Google เพื่อขอให้ชี้แจงสถานการณ์เกี่ยวกับการออกจากงานของทิมนิต เกบรู ทีมเก่าของเกบรูเรียกร้องให้รองประธาน เมแกน คาโชเลีย ถูกถอดออกจากสายการบริหารของทีม คาโชเลียถูกกล่าวหาว่าไล่เกบรูออกโดยไม่แจ้งผู้จัดการโดยตรงของเกบรูคือ แซมี เบงจิโอ ก่อน และทีมเก่าของเกบรูเรียกร้องให้คาโชเลียและดีนขอโทษสำหรับการปฏิบัติต่อเกบรู มิตเชลล์ได้วิพากษ์วิจารณ์ Google บนทวิตเตอร์เกี่ยวกับการปฏิบัติต่อพนักงานที่ทำงานเพื่อขจัดอคติและความเป็นพิษใน AI รวมถึงการที่ Google กล่าวหาว่าไล่เกบรูออก มิตเชลล์ถูกเลิกจ้างในภายหลังเนื่องจากถูกกล่าวหาว่านำเอกสารที่เป็นความลับทางธุรกิจและข้อมูลส่วนตัวของพนักงานคนอื่นออกไป

หลังจากข่าวเชิงลบเกี่ยวกับสถานการณ์การออกจากงานของเธอ ซันดาร์ พิชัย ประธานเจ้าหน้าที่บริหารของ Alphabet ซึ่งเป็นบริษัทแม่ของ Google ได้ออกมาขอโทษต่อสาธารณะบนทวิตเตอร์ โดยไม่ได้ชี้แจงว่าเกบรูถูกเลิกจ้างหรือลาออก และได้เริ่มการสอบสวนเหตุการณ์ดังกล่าวเป็นเวลาหลายเดือน เมื่อสิ้นสุดการตรวจสอบ ดีนประกาศว่า Google จะเปลี่ยน "แนวทางในการจัดการกับการออกจากงานของพนักงานบางคน" แต่ก็ยังไม่ได้ชี้แจงว่าการออกจาก Google ของเกบรูเป็นไปโดยสมัครใจหรือไม่ นอกจากนี้ ดีนยังกล่าวว่าจะมีการเปลี่ยนแปลงวิธีการตรวจสอบบทความวิจัยที่มีหัวข้อ "ละเอียดอ่อน" และเป้าหมายด้านความหลากหลาย ความเท่าเทียม และการไม่แบ่งแยก (DEI) จะถูกรายงานต่อคณะกรรมการบริหารของ Alphabet ทุกไตรมาส เกบรูเขียนบนทวิตเตอร์ว่าเธอ "ไม่คาดหวังอะไรมากไปกว่านี้" จาก Google และชี้ให้เห็นว่าการเปลี่ยนแปลงเหล่านี้เป็นผลมาจากคำขอที่เธอถูกกล่าวหาว่าถูกเลิกจ้าง แต่ไม่มีใครต้องรับผิดชอบต่อเรื่องนี้เลย หลังจากเหตุการณ์นี้ พนักงาน Google สองคนได้ลาออกจากตำแหน่งในบริษัท

หลังจากการออกจากงานของเธอ Google ได้จัดเวทีเพื่อหารือเกี่ยวกับประสบการณ์การเหยียดเชื้อชาติในบริษัท และพนักงานรายงานต่อ NBC News ว่าครึ่งหนึ่งของเวลาถูกใช้ไปกับการลดความน่าเชื่อถือของเกบรู ซึ่งพวกเขาตีความว่าบริษัทกำลังใช้เธอเป็นตัวอย่างสำหรับการพูดออกไป เวทีดังกล่าวตามมาด้วยการบำบัดทางจิตแบบกลุ่มสำหรับพนักงานผิวดำของ Google กับนักบำบัดที่ได้รับใบอนุญาต ซึ่งพนักงานกล่าวว่าเป็นการเพิกเฉยต่อความเสียหายที่พวกเขารู้สึกว่าการถูกไล่ออกของเกบรูได้ก่อให้เกิด เกบรูและคนอื่นๆ เชื่อว่าการถูกไล่ออกของเธอเป็นการตอบโต้และเป็นหลักฐานว่า Google มีการเหยียดเชื้อชาติในเชิงสถาบัน Google กล่าวว่า "ยังคงมุ่งเน้นไปที่งานสำคัญนี้และจะตรวจสอบข้อกังวลใดๆ อย่างละเอียด เพื่อให้แน่ใจว่า [Google] เป็นตัวแทนและมีความเท่าเทียม"

2.4. การก่อตั้งสถาบันวิจัยปัญญาประดิษฐ์แบบกระจายศูนย์ (DAIR)

ในเดือนมิถุนายน พ.ศ. 2564 เกบรูประกาศว่าเธอกำลังระดมทุนเพื่อ "เปิดตัวสถาบันวิจัยอิสระที่จำลองมาจากงานของเธอในทีมจริยธรรม AI ของ Google และประสบการณ์ของเธอใน Black in AI"

เมื่อวันที่ 2 ธันวาคม พ.ศ. 2564 เธอได้เปิดตัวสถาบันวิจัยปัญญาประดิษฐ์แบบกระจายศูนย์ (DAIR) ซึ่งคาดว่าจะบันทึกผลกระทบของปัญญาประดิษฐ์ต่อกลุ่มชายขอบ โดยมุ่งเน้นไปที่แอฟริกาและผู้อพยพชาวแอฟริกันในสหรัฐอเมริกา หนึ่งในโครงการเริ่มต้นขององค์กรมีแผนที่จะวิเคราะห์ภาพถ่ายดาวเทียมของเมืองต่างๆ ในแอฟริกาใต้ด้วย AI เพื่อทำความเข้าใจมรดกของการถือผิวได้ดีขึ้น

ในเดือนพฤศจิกายน พ.ศ. 2564 Nathan Cummings Foundation ซึ่งเป็นพันธมิตรกับ Open MIC และได้รับการรับรองโดย Color of Change ได้ยื่นข้อเสนอต่อผู้ถือหุ้นเรียกร้องให้มีการ "ตรวจสอบความเท่าเทียมทางเชื้อชาติ" เพื่อวิเคราะห์ "ผลกระทบเชิงลบ" ของ Alphabet ต่อ "ชุมชนคนผิวดำ ชาวพื้นเมือง และคนผิวสี (BIPOC)" ข้อเสนอนี้ยังเรียกร้องให้มีการสอบสวนว่า Google ตอบโต้พนักงานชนกลุ่มน้อยที่แสดงความกังวลเรื่องการเลือกปฏิบัติหรือไม่ โดยอ้างถึงการไล่ออกของเกบรู การเรียกร้องก่อนหน้านี้ให้ Google จ้างพนักงาน BIPOC เพิ่มขึ้น และงานวิจัยของเธอเกี่ยวกับอคติทางเชื้อชาติในเทคโนโลยีของ Google ข้อเสนอดังกล่าวเป็นไปตามคำขอที่ไม่เป็นทางการจากกลุ่มสมาชิกวุฒิสภาที่นำโดย คอรี บุ๊กเกอร์ เมื่อต้นปีนั้น ซึ่งอ้างถึงการแยกตัวของเกบรูออกจากบริษัทและงานของเธอด้วย

ในเดือนธันวาคม พ.ศ. 2564 Reuters รายงานว่า Google กำลังถูกสอบสวนโดย California Department of Fair Employment and Housing (DFEH) เกี่ยวกับการปฏิบัติต่อผู้หญิงผิวดำ หลังจากมีข้อร้องเรียนอย่างเป็นทางการจำนวนมากเกี่ยวกับการเลือกปฏิบัติและการคุกคามจากพนักงานปัจจุบันและอดีต การสอบสวนนี้เกิดขึ้นหลังจากเกบรูและพนักงาน BIPOC คนอื่นๆ รายงานว่าเมื่อพวกเขานำเสนอประสบการณ์การเหยียดเชื้อชาติและการเลือกปฏิบัติทางเพศต่อฝ่ายทรัพยากรบุคคล พวกเขาได้รับคำแนะนำให้ลาป่วยและเข้ารับการบำบัดผ่านโครงการช่วยเหลือพนักงาน (EAP) ของบริษัท เกบรูและคนอื่นๆ เชื่อว่าการถูกไล่ออกของเธอเป็นการตอบโต้และเป็นหลักฐานว่า Google มีการเหยียดเชื้อชาติในเชิงสถาบัน Google กล่าวว่า "ยังคงมุ่งเน้นไปที่งานสำคัญนี้และจะตรวจสอบข้อกังวลใดๆ อย่างละเอียด เพื่อให้แน่ใจว่า [Google] เป็นตัวแทนและมีความเท่าเทียม"

3. สาขาการวิจัยหลักและผลงาน

ทิมนิต เกบรูได้สร้างผลงานวิจัยที่สำคัญและมีอิทธิพลอย่างมากในหลายสาขาของปัญญาประดิษฐ์ โดยเฉพาะอย่างยิ่งในด้านจริยธรรมและความยุติธรรมของ AI

3.1. ความลำเอียงของอัลกอริทึมและความยุติธรรม

เกบรูได้ทำการวิจัยอย่างกว้างขวางเกี่ยวกับการระบุและลดอคติภายในระบบ AI งานของเธอเน้นย้ำถึงความจำเป็นในการพัฒนาเทคโนโลยีที่เป็นธรรมและเท่าเทียม โดยชี้ให้เห็นว่าระบบ AI ที่ไม่ได้รับการตรวจสอบอย่างรอบคอบอาจสะท้อนและขยายอคติที่มีอยู่ในข้อมูลการฝึกอบรม ซึ่งนำไปสู่ผลลัพธ์ที่ไม่เป็นธรรมสำหรับกลุ่มบุคคลบางกลุ่ม

3.2. เทคโนโลยีการจดจำใบหน้าและความแตกต่างทางเพศ/เชื้อชาติ

ผลงานวิจัยที่โดดเด่นที่สุดของเธอในสาขานี้คือโครงการ 'Gender Shades' ซึ่งร่วมกับ จอย บูโอลัมวินี โครงการนี้ได้ตรวจสอบซอฟต์แวร์รู้จำใบหน้าเชิงพาณิชย์ และพบว่ามีความแตกต่างอย่างมีนัยสำคัญในความแม่นยำของระบบ โดยเฉพาะอย่างยิ่งระบบมีประสิทธิภาพต่ำกว่ามากในการจดจำใบหน้าของผู้หญิงผิวดำ โดยมีอัตราความแม่นยำต่ำกว่าผู้ชายผิวขาวถึง 35% งานนี้เน้นย้ำถึงอันตรายของการนำเทคโนโลยีดังกล่าวไปใช้โดยไม่มีการตรวจสอบอคติอย่างละเอียด และเกบรูเชื่อว่าเทคโนโลยีรู้จำใบหน้าอันตรายเกินไปที่จะนำมาใช้เพื่อวัตถุประสงค์ในการบังคับใช้กฎหมายและความปลอดภัยในปัจจุบัน เธอได้ร่วมลงนามในจดหมายเรียกร้องให้ Amazon หยุดขายเทคโนโลยีรู้จำใบหน้าให้กับหน่วยงานบังคับใช้กฎหมายเนื่องจากมีอคติต่อผู้หญิงและคนผิวสี

3.3. ความเสี่ยงของแบบจำลองภาษาขนาดใหญ่ (LLMs)

เกบรูเป็นผู้ร่วมเขียนบทความวิจัยที่มีอิทธิพลอย่างมากเรื่อง "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜" บทความนี้ได้สรุปผลการวิจัยเกี่ยวกับความเสี่ยงที่เกี่ยวข้องกับแบบจำลองภาษาขนาดใหญ่ (LLMs) โดยอภิปรายถึงประเด็นสำคัญหลายประการ ได้แก่:

- ต้นทุนด้านสิ่งแวดล้อม: การฝึกอบรม LLMs ขนาดใหญ่ต้องใช้พลังงานมหาศาล ซึ่งส่งผลให้เกิดการปล่อยคาร์บอนจำนวนมาก

- ต้นทุนทางการเงิน: การพัฒนาและการบำรุงรักษา LLMs มีค่าใช้จ่ายสูง ซึ่งจำกัดผู้เล่นในอุตสาหกรรมให้เหลือเพียงบริษัทขนาดใหญ่ไม่กี่แห่ง

- ความไม่โปร่งใส: แบบจำลองเหล่านี้มีความซับซ้อนมากจนยากที่จะเข้าใจว่าพวกมันทำงานอย่างไร ซึ่งทำให้ยากต่อการระบุและแก้ไขอคติหรือข้อผิดพลาด

- อคติ: LLMs สามารถแสดงอคติที่มีอยู่ในข้อมูลที่พวกมันได้รับการฝึกฝน ซึ่งอาจนำไปสู่การเลือกปฏิบัติหรือการสร้างเนื้อหาที่ไม่เหมาะสม

- การนำไปใช้ในทางที่ผิด: มีศักยภาพที่ LLMs จะถูกใช้เพื่อเผยแพร่ข้อมูลเท็จ หรือสร้างเนื้อหาที่เป็นอันตราย

3.4. จริยธรรม AI และผลกระทบทางสังคม

งานของเกบรูยังสำรวจผลกระทบทางจริยธรรมและสังคมของเทคโนโลยี AI อย่างกว้างขวาง โดยเฉพาะอย่างยิ่งต่อชุมชนชายขอบ เธอวิเคราะห์ว่า AI อาจทำให้ความไม่เท่าเทียมทางสังคมที่มีอยู่แย่ลงได้อย่างไร และนำเสนอแนวทางแก้ไขสำหรับการพัฒนา AI ที่มีความรับผิดชอบ เธอเน้นย้ำถึงความสำคัญของการพิจารณาผลกระทบทางสังคมในทุกขั้นตอนของการออกแบบ การพัฒนา และการนำระบบ AI ไปใช้ เพื่อให้แน่ใจว่าเทคโนโลยีนี้จะให้บริการแก่ทุกคนอย่างเป็นธรรมและไม่สร้างความเสียหาย

4. การเคลื่อนไหวทางสังคมและการสนับสนุน

ทิมนิต เกบรูไม่เพียงเป็นนักวิจัยที่โดดเด่น แต่ยังเป็นนักเคลื่อนไหวทางสังคมที่กระตือรือร้น โดยเฉพาะอย่างยิ่งในการส่งเสริมความหลากหลาย การยอมรับ และความยุติธรรมทางสังคมภายในอุตสาหกรรมเทคโนโลยีและการวิจัย AI

4.1. การร่วมก่อตั้งและกิจกรรมของ Black in AI

ในปี พ.ศ. 2559 เกบรูได้ร่วมก่อตั้งองค์กร Black in AI กับ เรดิเอต อาเบเบ หลังจากที่เธอสังเกตเห็นว่ามีนักวิจัยผิวดำเพียงไม่กี่คนในการประชุมด้านปัญญาประดิษฐ์ชั้นนำ Black in AI มีพันธกิจในการเพิ่มการเป็นตัวแทนและการมองเห็นของนักวิจัยผิวดำในสาขา AI รวมถึงการส่งเสริมความเป็นอยู่ที่ดีของพวกเขา องค์กรนี้จัดเวิร์คช็อปในการประชุม Neural Information Processing Systems (NIPS) ประจำปีตั้งแต่ปี พ.ศ. 2560 เพื่อสร้างชุมชนและให้โอกาสแก่นักวิจัยผิวดำในการนำเสนอผลงานและสร้างเครือข่าย

4.2. การส่งเสริมความหลากหลายและการยอมรับในเทคโนโลยี

เกบรูได้ทุ่มเทความพยายามอย่างมากในการสนับสนุนให้ผู้หญิงและชนกลุ่มน้อยที่ถูกกีดกันมีส่วนร่วมในสาขา STEM โดยเฉพาะอย่างยิ่งในการวิจัย AI เธอได้วิพากษ์วิจารณ์ "วัฒนธรรมแบบชมรมเด็กผู้ชาย" ที่พบในอุตสาหกรรมเทคโนโลยี และเปิดเผยประสบการณ์การคุกคามทางเพศที่เธอเคยประสบในการประชุมต่างๆ เธอเชื่อว่าการขาดความหลากหลายในทีมพัฒนา AI นำไปสู่อคติในระบบ AI และการเพิ่มความหลากหลายเป็นสิ่งจำเป็นในการแก้ไขปัญหานี้

4.3. การวิจารณ์ TESCREAL และจริยธรรมเทคโนโลยี

เกบรูและเอมิล พี. ตอร์เรส ได้ร่วมกันบัญญัติศัพท์ย่อใหม่ว่า TESCREAL เพื่อวิพากษ์วิจารณ์กลุ่มปรัชญาแห่งอนาคตที่ทับซ้อนกัน ซึ่งได้แก่ ทรานส์ฮิวแมนนิซึม, เอ็กซ์โทรเพียนนิซึม, ซิงกูลาริเทเรียนนิซึม, รัสเซียน คอสมิซึม, เหตุผลนิยม, การเห็นแก่ประโยชน์ผู้อื่นอย่างมีประสิทธิผล และ ลัทธิระยะยาวนิยม เกบรูมองว่าปรัชญาเหล่านี้เป็นอิทธิพลที่เอนเอียงไปทางขวาในบริษัทบิ๊กเทค และเปรียบเทียบผู้สนับสนุนปรัชญาเหล่านี้กับ "นักสุพันธุกศาสตร์ในศตวรรษที่ 20" ในแง่ของการผลิตโครงการที่เป็นอันตรายแต่กลับนำเสนอว่า "เป็นประโยชน์ต่อมนุษยชาติ" เกบรูได้วิพากษ์วิจารณ์การวิจัยปัญญาประดิษฐ์ทั่วไป (AGI) ว่ามีรากฐานมาจากสุพันธุกศาสตร์ และระบุว่าควรเปลี่ยนจุดเน้นจากการสร้าง AGI เนื่องจากเป็นแนวปฏิบัติที่ไม่ปลอดภัยโดยเนื้อแท้

5. รางวัลและการยอมรับ

ทิมนิต เกบรูได้รับการยกย่องและรางวัลมากมายสำหรับผลงานบุกเบิกของเธอในด้านจริยธรรม AI และการสนับสนุนความหลากหลายในเทคโนโลยี

- รางวัลนวัตกรรม AI แห่งปี 2562 ของ VentureBeat: เกบรู, จอย บูโอลัมวินี และ อินิโอลูวา เดโบราห์ ราจี ได้รับรางวัลนี้ในหมวดหมู่ "AI for Good" สำหรับงานวิจัยของพวกเขาที่เน้นย้ำถึงปัญหาสำคัญของอคติทางอัลกอริทึมในการจดจำใบหน้า

- 50 ผู้นำที่ยิ่งใหญ่ที่สุดของโลก โดย Fortune (พ.ศ. 2564): เธอได้รับการจัดอันดับให้เป็นหนึ่งในผู้นำที่มีอิทธิพลมากที่สุดในโลก

- สิบผู้ทรงอิทธิพลที่กำหนดทิศทางวิทยาศาสตร์ในปี พ.ศ. 2564 โดย Nature: วารสารวิทยาศาสตร์ Nature ได้รวมชื่อเธอไว้ในรายชื่อนักวิทยาศาสตร์สิบคนที่บทบาทสำคัญในการพัฒนาทางวิทยาศาสตร์ในปีนั้น

- บุคคลผู้ทรงอิทธิพลที่สุดประจำปี พ.ศ. 2565 โดย Time: นิตยสาร Time ได้ยกย่องเธอว่าเป็นหนึ่งในบุคคลผู้ทรงอิทธิพลที่สุดประจำปี

- รางวัล Great Immigrants Awards จาก Carnegie Corporation of New York (พ.ศ. 2566): เธอได้รับรางวัลนี้เพื่อเป็นการยกย่องการมีส่วนร่วมที่สำคัญของเธอในสาขาจริยธรรมปัญญาประดิษฐ์

- 100 ผู้หญิงของ BBC (พ.ศ. 2566): เธอได้รับการจัดอันดับในรายชื่อ "100 ผู้หญิง" ของ BBC ในฐานะหนึ่งในผู้หญิงที่สร้างแรงบันดาลใจและมีอิทธิพลมากที่สุดในโลก

6. ผลกระทบและมรดก

ทิมนิต เกบรูมีอิทธิพลอย่างลึกซึ้งต่อวาทกรรมด้านจริยธรรม AI และแนวปฏิบัติในอุตสาหกรรมเทคโนโลยี การวิจัยของเธอเกี่ยวกับความลำเอียงของอัลกอริทึม โดยเฉพาะอย่างยิ่งในเทคโนโลยีการจดจำใบหน้า ได้เผยให้เห็นข้อบกพร่องที่สำคัญในระบบ AI ที่ใช้กันอย่างแพร่หลาย ซึ่งนำไปสู่การตระหนักรู้ที่เพิ่มขึ้นเกี่ยวกับความจำเป็นในการออกแบบและพัฒนา AI ที่เป็นธรรมและมีความรับผิดชอบ

การออกจาก Google ของเธอในปี พ.ศ. 2563 ได้จุดชนวนให้เกิดการถกเถียงอย่างรุนแรงในระดับโลกเกี่ยวกับจริยธรรมของบริษัทเทคโนโลยีขนาดใหญ่ การเซ็นเซอร์งานวิจัย และการปฏิบัติต่อพนักงานที่หยิบยกข้อกังวลด้านจริยธรรมขึ้นมา เหตุการณ์นี้ได้กระตุ้นให้เกิดการตรวจสอบภายในและภายนอกอย่างที่ไม่เคยมีมาก่อนในอุตสาหกรรมเทคโนโลยี โดยบังคับให้บริษัทต่างๆ ต้องเผชิญหน้ากับคำถามยากๆ เกี่ยวกับความหลากหลาย ความเท่าเทียม และการไม่แบ่งแยก รวมถึงความโปร่งใสในการตัดสินใจด้าน AI

การก่อตั้งสถาบันวิจัยปัญญาประดิษฐ์แบบกระจายศูนย์ (DAIR) ของเกบรูเป็นมรดกที่สำคัญ ซึ่งแสดงถึงความมุ่งมั่นของเธอในการสร้างพื้นที่วิจัยอิสระที่เน้นผลกระทบของ AI ต่อกลุ่มชายขอบ โดยเฉพาะในแอฟริกาและชุมชนผู้อพยพ DAIR เป็นแบบจำลองสำหรับแนวทางการวิจัย AI ที่เน้นมนุษย์เป็นศูนย์กลางและขับเคลื่อนโดยชุมชน ซึ่งท้าทายกระบวนทัศน์ที่ครอบงำโดยบริษัทเทคโนโลยีขนาดใหญ่

นอกจากนี้ การเคลื่อนไหวทางสังคมของเธอ โดยเฉพาะอย่างยิ่งผ่าน Black in AI ได้เพิ่มการเป็นตัวแทนและการมองเห็นของนักวิจัยผิวดำในสาขา AI อย่างมีนัยสำคัญ ซึ่งช่วยสร้างชุมชนที่สนับสนุนและส่งเสริมความหลากหลายในสาขาที่สำคัญนี้ การวิพากษ์วิจารณ์ปรัชญา TESCREAL ของเธอยังได้จุดประกายการอภิปรายที่สำคัญเกี่ยวกับอิทธิพลของแนวคิดแห่งอนาคตบางอย่างที่มีต่อทิศทางของเทคโนโลยี AI และผลกระทบทางสังคมที่อาจเกิดขึ้น

โดยรวมแล้ว ผลกระทบและมรดกของทิมนิต เกบรูคือการเป็นผู้บุกเบิกที่กล้าหาญซึ่งไม่เพียงแต่ก้าวหน้าทางวิทยาศาสตร์เท่านั้น แต่ยังท้าทายสถานะเดิมและสนับสนุนชุมชนชายขอบในด้านเทคโนโลยีอย่างไม่ลดละ เธอได้กำหนดทิศทางใหม่ให้กับวาทกรรมด้านจริยธรรม AI และเป็นแรงบันดาลใจให้เกิดการเปลี่ยนแปลงที่จำเป็นอย่างยิ่งในอุตสาหกรรมนี้

7. สิ่งพิมพ์ที่เลือก

- Gebru, Timnit. "Visual computational sociology: computer vision methods and challenges." วิทยานิพนธ์ปริญญาเอก (2560).

- Gebru, Timnit, et al. "Using deep learning and Google Street View to estimate the demographic makeup of neighborhoods across the United States." Proceedings of the National Academy of Sciences เล่มที่ 114, ฉบับที่ 50 (2560): หน้า 13108-13113.

- Buolamwini, Joy, and Timnit Gebru. "Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification." Proceedings of Machine Learning Research เล่มที่ 81 (2561): หน้า 1-15.

- Gebru, Timnit. "Race and Gender." ใน The Oxford Handbook of Ethics of AI. สำนักพิมพ์ Oxford University Press (2563): หน้า 251-269.

- Gebru, Timnit, and Émile P. Torres. "The TESCREAL bundle: Eugenics and the promise of utopia through artificial general intelligence." First Monday เล่มที่ 29, ฉบับที่ 4 (2567).

- Gebru, Timnit, et al. "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜" (2563).

8. ดูเพิ่ม

- Coded Bias

- แคลร์ สเตเปิลตัน

- เมเรดิธ วิตเทกเกอร์

- โซฟี จาง